7 de Noviembre, 7 de la tarde, Fundación del Colegio Oficial de Arquitectos de Madrid (COAM). El arquitecto americano Richard Gage se pasó por allí, para demostrar (otro más) que las torres gemelas y el edificio 7 del World Trade Center cayeron debido a una demolición controlada. No es una charla aislada, porque Richard Gage está de gira por Europa, comenzando por Madrid.

A pesar de tener ya planes para esa tarde (aunque no se lo crean, los malvados escépticos también tenemos vida social, y no nos pasamos la vida pegados al ordenador o la tele a ver cual es la última de Iker Jiménez) me pude acercar un ratito a ver que se cocía.

Hay que reconocer que el evento tuvo éxito en cuanto a afluencia de público. Llegué 15 minutos antes del comienzo, y tuve que esperar a ver si había hueco porque el aforo estaba prácticamente lleno. A pesar de todo, pude entrar y coger asiento en la sala principal. En una sala exterior proyectaban la imagen y se oía la traducción simultánea.

Cuando entré, le estaban entrevistando para una televisión local de Vallecas. Poco pude oír porque le pillé justo al final, y sólo pude entender cómo hablaba de que había que “ceñirse a las evidencias”.

Y mientras esperábamos la cola para acceder al salón de actos, en un mostrador repartían tarjetitas con un resumen de esas evidencias, y de cómo éstas corroboran la teoría de la demolición controlada. También vendían CD’s al módico precio de 20 euros, que al fin y al cabo, la noble labor de abrir los ojos al mundo no se hace gratis.

Richard Gage se presenta como arquitecto desde hace 20 años, en la zona de la bahía de San Francisco. Miembro de la asociación de arquitectos e ingenieros por la verdad del 11-S apoyada ni más ni menos que por la friolera e impresionante cantidad de unos 500 arquitectos e ingenieros (*), todos ellos pidiendo una nueva investigación de los eventos de aquel día. Sin embargo, parece ser que ya no ejerce como arquitecto. Según él mismo dijo, ahora dedica el 100% de su tiempo a divulgar la teoría de la demolición controlada. De ahí el tour que tiene previsto realizar por toda Europa.

Tras la presentación, Gage denunció la existencia de una nueva ley (HR 1955) según la cual, cualquiera que dude de la versión oficial puede ser considerado terrorista. El texto de la ley anda por aquí, y dejaremos que sean quienes entienden de leyes los que opinen si la ley dice eso, o si es una nueva versión del argumento de persecución Galileana

Gage considera importante saber qué pasó realmente el 11 de Septiembre de 2001, para prevenir que otro 11-S ocurra algún día, algo en lo que creo la mayoría podemos estar de acuerdo.

Preguntó Gage por qué tipo de público tenía: unos 10 “oficialistas”, unos 50 “dudosos “, y otros 50 “convencidos de la conspiración”. En cuanto a formación, unos 20 entre arquitectos e ingenieros, y el resto, gente “normal” (sic), de lo cual llegó a decir “eso está bien”. Cada uno que lo interprete como quiera, pero siendo malo uno diría que tenía un público fácil, lo cual le agradaba.

Lo que no terminé por entender fue su obsesión por conocer los números exactos. Y tampoco quiero pensar mal en exceso.

Y así, empezó la chicha del acto, remarcando que sólo se iba a fijar en los hechos basados en ciencia, seguido de una mención a Pearl Harbour, y una introducción en forma de video del 11-S. El video, como no, decía que las torres gemelas cayeron en apenas 10 segundos. Mal empezamos, si partimos de hechos falsos, dado que el tiempo en que cayeron las torres fue más bien de unos 15 segundos.

El método científico tiene un esquema claro y fácil de seguir: tenemos unas evidencias, las interpretamos para elaborar una hipótesis, hacemos experimentos repetibles de los que sacamos conclusiones y entonces validamos o descartamos la hipótesis para buscar una nueva. Más o menos, todos estaremos de acuerdo en esa descripción.

En 2005, FEMA y NIST habían dicho que no encontraron evidencias de una demolición controlada. La crítica de Gage es que no se puede encontrar lo que no se busca. Pero también se le puede decir a Gage que si no hay motivos para buscar algo determinado, hacerlo es dar palos de ciego, algo que en alguna ocasión puede llevar a descubrimientos fantásticos, pero la mayoría de las veces a perder el tiempo (y malgastar el dinero). Aplicando el método científico esquematizado de antes, podríamos decir que los experimentos de FEMA y NIST confirmaban las hipótesis que les sugerían las evidencias disponibles, y por tanto no era necesario buscar en otra dirección.

Así, empezamos a repasar las características de los derrumbes. Empezamos por al torre 7. Fue la última en caer, pero tiene su lógica empezar por aquí. Creo que todos podemos coincidir en que su derrumbe se parece a una demolición controlada. La estrategia es clara: convencer primero de lo fácil (el WTC7 fue demolido controladamente porque se parece mucho a una demolición controlada desde la base del edificio), que luego será más fácil de convencer de lo difícil (la demolición controlada de arriba a abajo de las torres gemelas).

Remarco parece, porque al final la argumentación se reduce a un “confía en tus sentidos”, “tus sentidos no te engañan”. El primer elemento para convencernos de esta demolición controlada es… un video de una demolición controlada desde la base del edificio. En el video se apreciaba bien la explosión en los pisos bajos, y un segundo después cómo la estructura se cae.

Lo que no se aprecia en el video en cambio, es el sonido. Es un video mudo, donde no se oyen explosiones. De esta forma, al ver a continuación el derrumbe del edificio 7 uno no se da cuenta que falta el sonido de las explosiones, a pesar de que sí se oye el sonido del edificio cayendo. Eso sí, nos ofrece el sonido de una grabación de una emisión de radio, en la que la locutora entrevista a alguien de emergencias, diciendo que había oído como el sonido de un trueno o relámpago (literalmente, “clap of thunder”) justo antes de la caída. La transcripción (y sonido) se pueden encontrar aquí

Se nota que Gage se dedica el 100% a la divulgación, y tiene tiempo para hacer sus deberes. En Agosto de 2008, el NIST sacó por fin el informe sobre el colapso del WTC7. Y ya se lo ha leído a fondo.

Resumiendo, lo que señala el informe como la secuencia más probable del colapso, es que tras la caída de la torre norte (la segunda en caer), el WTC7 sufrió daños visibles en la fachada. También aparecieron algunos incendios, de los cuales, el que se dio entre las plantas 7 y 13 fue el causante final del derrumbe. El incendio comenzó en el lado suroeste del edificio, y se propagó a la zona norte (algo de lo que Gage se sorprende, a pesar de haber dicho previamente que es bien sabido que los fuegos no están más de 20 minutos en una zona concreta), y de la zona norte, a la zona este.

El incendio y las variaciones de temperatura dilataron y contrajeron los pisos y columnas, hasta que al final, en el lado este, algunos pisos se desprendieron de las columnas 79, 80 y 81. Éstas eran las más largas del edifcio, y además eran las que más peso soportaban. Al caerse los pisos, las columnas se quedan sin apoyos laterales, y comienzan un proceso de “pandeo” que las hace doblarse sobre sí mismas, comenzando el derrumbe general de todo el edificio.

Esta era una buena ocasión para que Gage mostrara sus conocimientos de arquitectura y explicara si esas columnas eran o no tan importantes. Y si el perder esas columnas hubiera hecho que el edificio se cayera como lo hizo, tal y como sostiene el NIST.

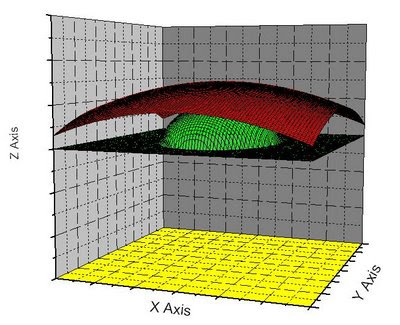

Un edificio se cae porque sus columnas dejan de soportar el peso. Cómo se eliminen, es independiente de lo que pase luego. De hecho, el NIST también examinó la hipótesis de la demolición controlada. Sabiendo que el edificio cae si se eliminan esas columnas, calcularon la cantidad de explosivo mínimo: una carga direccional de apenas 4 Kg de RDX en la columna 79. Al explotar, se elimina la columna y el edificio cae como se ve en las imágenes. Es una demolición controlada que cumple con los requisitos que piden los conspiranoicos, y coincide con los estudios de qué pasa cuando se elimina la columna 79.

Así que la pregunta para Gage, como arquitecto que es, debería ser si el hecho de perder el apoyo de las columnas 79, 80 y 81 hubieran tirado al suelo al WTC7. Luego, si quiere, podríamos entrar en si se perdieron por un incendio, o por una carga explosiva, pero el primer punto es claro: eliminar esas columnas ¿tira abajo el edificio, sí o no?. La mayoría de los que estábamos allí no poseíamos conocimientos suficientes para saberlo, Gage podría haber explicado si era así o no dado que él sí posee esos conocimientos. Pero, o me perdí ese punto, no entró en él.

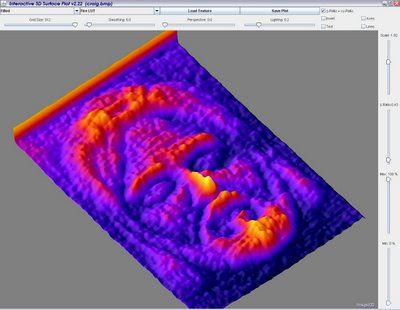

En cambio, prefiere mostrar una imagen de la simulación del NIST. Según la simulación, unos segundos después del inicio de la caída el edificio empieza a retorcerse sobre sí mismo, algo que según él, no se aprecia en las imágenes. Sin embargo, estos giros de la estructura aparecen en los pisos más bajos, que están tapados por otros edificios en los videos, por lo que no podemos saber realmente si eso fue así.

Y para poco más me dio el ratillo que pasé allí. De lo poco que vi y oí, me pareció que la argumentación se reducía a fiarse de los sentidos para comprobar cómo un hecho se parece a otros. Pero en fin, igual después sí que sacó a relucir su experiencia como arquitecto y me lo perdí.

Una de las curiosidades que tenía para acudir al acto era saber si algún arquitecto o ingeniero con experiencia en construcción de edificios, o demoliciones, planteaba algún debate sobre las afirmaciones de Gage. Visto el tipo público asistente, tengo mis dudas al respecto. Y en todo caso, tampoco podría haberme quedado a verlo.

-Hay que ceñirse a las evidencias - le oí decir al entrar.

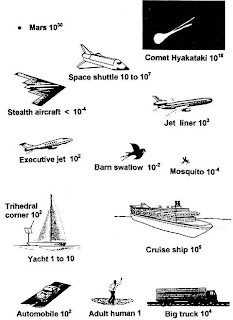

En las torres Norte y Sur, la “evidencia” sugiere la presencia de unas nubes que se parecen a nubes piroclásticas, lo que sugiere el uso de explosivos. Una vez más, se nos está pidiendo que tomemos un parecido como evidencia. Las nubes piroclásticas surgen en algunas erupciones de volcanes, como la del Vesubio que llevó a la destrucción de Pompeya y Herculano. Es una nube de gas a muy alta temperatura que cae a alta velocidad volcán abajo.

¿Qué tiene que ver una erupción volcánica con una bomba, o demolición? Pues no lo sé. Tampoco se entiende por qué la gente que terminó cubierta por esa nube no murió carbonizada.

Lo cierto es que si los conspiranoicos fueran tan sólo el 1% de exigentes con sus teorías de lo que son con la versión oficial, se quedarían sin conspiración.

Actualización

(*) Compárese con los 123.000 miembros de la ASCE (American Society of Civil Engineers), y los 80.000 miembros de la AIA (American Institute of Architecs) (fuente) que al contrario de los 500 arquitectos a los que representa Gage, no dudan de los informes del NIST. Mucho conspirador suelto, es lo que hay

Otra Actualización

Terminó la gira europea, y Gage la resume en su web. Por supuesto, fue un éxito porque acudió gran cantidad de gente. Y la manía por contar qué tipo de asistentes tenía era por lo que me temía:

Cientos de arquitectos e ingenieros vinieron a ver de qué iba la controversia

No se cómo fue en otros países. En Madrid, de unos ~120 asistentes, sólo 20 eran ingenieros o arquitectos (un 16%). En París, parece que la proporción fue más o menos la misma: unos 40 de 240. Si la proporción fue la misma en el resto de países, entonces sumando los de todos los países, sí, llegaron al centenar, y representan al 16% del público. Otra cosa es si se creían o no los argumentos de Gage.

Y la otra frase me hace gracia es la de:

Y el número de manos alzadas reveló que apenas nadie apoyaba la conspiración oficial y la historia del fuego después de mostrar las evidencias

Se le olvida contar que el número de manos alzadas antes de dar las evidencias ya era elevado, por lo que en realidad, estaba hablando a un público ya convencido o predispuesto.

Si lo que intentaba contando tipos de asistentes era demostrar a posteriori que había convencido a ingenieros y arquitectos de "la Verdad"... pues simplemente me parece una manipulación.